Машинное обучение становится все более популярным и востребованным методом анализа данных в настоящее время. Одной из важнейших задач в области машинного обучения является классификация данных, которая позволяет отнести объекты к определенным категориям или классам на основе имеющихся признаков.

Однако чтобы оценить качество работы алгоритма классификации, необходимы специальные метрики, позволяющие измерить предсказательную способность модели. Метрики классификации представляют собой числовые показатели, которые позволяют оценить точность, полноту, специфичность и другие характеристики классификационных моделей.

В данной статье мы рассмотрим основные метрики классификации, которые широко применяются в машинном обучении. Мы изучим, как использовать эти метрики для оценки производительности модели, а также разберемся, какие показатели следует учитывать при выборе наилучшей модели классификации для задачи.

К пониманию и использованию метрик классификации важно приступать с осознанием задачи классификации и связанных с ней особенностей данных. Знание основных метрик классификации позволит проводить более точные и объективные сравнения различных алгоритмов классификации и выбирать наиболее подходящие модели для решения конкретных задач.

- Понятие метрик классификации

- Метрика классификации: определение и основные цели

- Роль метрик классификации в машинном обучении

- Основные показатели метрик классификации

- Точность

- Формула расчета точности

- Применение точности в машинном обучении

- Полнота

- Формула расчета полноты

- Применение полноты в машинном обучении

- F-мера

- Формула расчета F-меры

- Применение F-меры в машинном обучении

- Дополнительные показатели метрик классификации

- Матрица ошибок

- Формула расчета матрицы ошибок

- Применение матрицы ошибок в машинном обучении

- ROC-кривая и AUC-ROC

- Формула расчета ROC-кривой и AUC-ROC

- Применение ROC-кривой и AUC-ROC в машинном обучении

- Интерпретация результатов метрик классификации

- Оценка качества модели по метрикам классификации

- Сравнение моделей на основе метрик классификации

- 💥 Видео

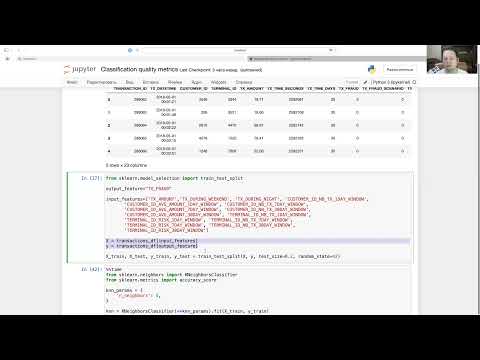

Видео:КЛАССИФИКАЦИЯ В МАШИННОМ ОБУЧЕНИИ на Python. ТОП-7 АЛГОРИТМОВ КЛАССИФИКАЦИИ на Практике!Скачать

Понятие метрик классификации

Метрики классификации в машинном обучении представляют собой числовые показатели, которые оценивают качество работы алгоритмов классификации. Они помогают определить, насколько точно модель классификации разделяет объекты в задаче.

Основной задачей метрик классификации является определение, насколько корректно алгоритм классификации предсказывает метки классов для тестовых данных. Путем анализа этих метрик можно оценить, насколько успешно модель делает прогнозы и какие ошибки она допускает.

Существует несколько основных показателей метрик классификации, которые оценивают различные аспекты работы алгоритма классификации:

Точность (Accuracy): показывает, как много объектов модель классифицировала верно в общем числе всех объектов. Отражает общую эффективность модели.

Матрица ошибок (Confusion Matrix): представляет собой таблицу, в которой строки соответствуют реальным меткам классов, а столбцы – предсказанным меткам классов. Используя эту матрицу, можно вычислить различные показатели, такие как точность, полноту и F-меру.

Точность (Precision): показывает, как много объектов, классифицированных как положительные, действительно являются положительными. Это позволяет оценить способность модели правильно идентифицировать объекты положительного класса.

Полнота (Recall): показывает, как много объектов положительного класса модель смогла обнаружить. Она отражает способность модели правильно определять все реальные положительные объекты.

F-мера (F1-measure): объединяет точность и полноту в один показатель и позволяет оценить баланс между ними. Она является гармоническим средним между точностью и полнотой, и чем выше ее значение, тем лучше.

Понимание и использование метрик классификации позволяет оценить качество работы алгоритмов классификации и выбрать наиболее подходящую модель для решения конкретной задачи.

Видео:Оценка классификация в машинном обучении [False positive vs False Negative] Какие метрики?Скачать

![Оценка классификация в машинном обучении [False positive vs False Negative] Какие метрики?](https://i.ytimg.com/vi/RmMyGoTxABY/0.jpg)

Метрика классификации: определение и основные цели

Основная цель использования метрики классификации — сравнение различных алгоритмов классификации и выбор наиболее эффективного из них. Метрики помогают оценить качество работы модели на реальных данных и определить ее надежность и предсказательные способности.

Существует несколько основных метрик классификации, которые широко применяются в машинном обучении:

1. Точность (Accuracy): показывает, как часто модель правильно классифицирует объекты. Она вычисляется как отношение числа правильно классифицированных объектов к общему числу объектов.

2. Точность (Precision): показывает, какую долю из классифицированных моделью объектов действительно принадлежит к положительному классу. Она вычисляется как отношение числа истинно положительных объектов к сумме числа истинно положительных и ложно положительных объектов.

3. Полнота (Recall): показывает, какую долю объектов положительного класса модель правильно классифицирует. Она вычисляется как отношение числа истинно положительных объектов к сумме числа истинно положительных и ложно отрицательных объектов.

4. F-мера (F-measure): комбинированный показатель, который учитывает и точность, и полноту классификации. Она вычисляется как среднее гармоническое между точностью и полнотой. F-мера позволяет сбалансировано оценить качество работы модели.

Выбор метрики классификации зависит от конкретной задачи и важности определенных типов ошибок. Например, для задачи выявления мошеннических транзакций более важна точность, чтобы минимизировать число ложных срабатываний.

Таким образом, использование метрик классификации позволяет оценить качество работы модели и принять решение о выборе наилучшего алгоритма для конкретной задачи.

Видео:ACCURACY | МЕТРИКИ КЛАССИФИКАЦИИ В МАШИННОМ ОБУЧЕНИИСкачать

Роль метрик классификации в машинном обучении

Одной из наиболее распространенных метрик является точность (accuracy). Эта метрика показывает, насколько модель правильно классифицирует объекты и определяет долю верных ответов. Однако, точность не всегда является достаточным показателем для оценки качества модели, особенно в случае несбалансированных классов.

Для более полной оценки работы модели используются другие метрики, например, полнота (recall), точность (precision), F-мера (F-score) и площадь под ROC-кривой (ROC AUC). Полнота показывает, насколько модель находит все положительные объекты, точность показывает, как много из классифицированных как положительные объекты действительно являются положительными, F-мера объединяет в себе оба этих показателя, а ROC AUC оценивает способность модели различать классы.

Метрики классификации позволяют принимать обоснованные решения в контексте машинного обучения. Они помогают выбрать наилучшую модель из нескольких, проанализировать показатели модели для разных классов, выявить проблемные ситуации, связанные с ложными срабатываниями или пропусками объектов, а также настроить параметры моделей для достижения наилучшего качества.

Видео:Машинное обучение для чайниковСкачать

Основные показатели метрик классификации

Существуют различные показатели, которые помогают измерить качество классификации:

1. Точность (Accuracy)

Данный показатель отражает отношение правильно классифицированных объектов к общему числу объектов. Он позволяет оценить, насколько модель верно предсказывает классы. Точность выражается в процентах и чем ближе значение к 100%, тем точнее классификация.

2. Полнота (Recall)

Полнота показывает, насколько модель корректно определяет объекты положительного класса. Этот показатель позволяет оценить способность модели верно идентифицировать объекты, которые действительно принадлежат целевому классу. Полнота выражается в процентах и чем ближе значение к 100%, тем выше способность модели искать объекты положительного класса.

3. Точность положительного класса (Precision)

Этот показатель позволяет оценить, насколько модель верно определяет объекты положительного класса. Он отражает отношение правильно определенных объектов данного класса к общему числу объектов, которые были определены как положительные. Точность положительного класса выражается в процентах и показывает, насколько модель точна в определении объектов положительного класса.

4. F1-мера

Данная метрика является средним гармоническим между полнотой и точностью и позволяет учесть оба показателя при оценке качества модели. F1-мера выражается числом от 0 до 1, где 1 соответствует идеальному качеству модели, а 0 – полному отсутствию предсказательной способности.

5. Матрица ошибок (Confusion Matrix)

Матрица ошибок представляет собой таблицу, в которой показаны реальные и предсказанные классы объектов. Она позволяет оценить количество верно и неверно классифицированных объектов каждого класса и выявить возможные несоответствия. Матрица ошибок очень полезна для анализа ошибок модели и нахождения способов их исправления.

Выбор и использование определенных метрик классификации зависит от конкретной задачи и требований к модели. Необходимо учитывать особенности данных и цель классификации для получения наиболее точных и релевантных результатов.

Видео:Метрики качества классификации: accuracy, precision, recall, F-scoreСкачать

Точность

Точность вычисляется как отношение количества правильно предсказанных классов к общему числу примеров. Иными словами, это число правильно классифицированных примеров, деленное на общее число примеров. Чем выше точность, тем лучше модель справляется с задачей классификации.

Например, если модель правильно классифицировала 90 из 100 примеров, то точность составит 90%.

Точность полезна в случаях, когда важно избегать ложных положительных результатов. Например, в медицинской диагностике, где ложное положительное предсказание может привести к ненужным и дорогостоящим дополнительным исследованиям. Но в некоторых задачах, где важно обнаружить все положительные примеры, даже за счет увеличения ложных положительных результатов, точность может быть не наиболее подходящей метрикой.

Важно помнить, что точность следует рассматривать в сочетании с другими метриками, такими как полнота, F-мера и матрица ошибок, чтобы иметь полное представление о качестве модели классификации.

Формула расчета точности

Формула расчета точности имеет следующий вид:

Точность = (Количество правильных предсказаний) / (Общее количество предсказаний)

Чтобы посчитать точность, нужно поделить количество правильных предсказаний на общее количество предсказаний и умножить на 100%, чтобы получить результат в процентах.

Таким образом, точность отображает долю правильных предсказаний модели. Чем выше точность, тем лучше модель классификации справляется с задачей.

Применение точности в машинном обучении

Применение точности в машинном обучении включает в себя следующие аспекты:

- Оценка качества модели: Точность позволяет оценить качество модели классификации. Высокая точность говорит о том, что модель правильно классифицирует объекты данных, а низкая точность может говорить о наличии проблем с моделью.

- Выбор модели: Точность может использоваться для сравнения различных моделей классификации и выбора наилучшей модели для конкретной задачи. При сравнении моделей можно выбрать модель с наибольшей точностью.

- Настройка параметров модели: Для достижения более высокой точности можно использовать различные методы настройки параметров модели. Можно изменять гиперпараметры модели, обучающий алгоритм, размеры выборки и т.д. и затем сравнивать полученные результаты точности.

Точность является важной метрикой классификации и находит применение во многих задачах машинного обучения. Однако, следует помнить, что точность не всегда является достаточной для оценки качества модели, особенно в случаях, когда классы несбалансированы или ошибки разных типов имеют разную важность. В таких случаях рекомендуется использовать другие метрики, такие как полнота, точность и F-мера.

Видео:PRECISION, RECALL, CONFUSION MATRIX, ТОЧНОСТЬ, ПОЛНОТА, МАТРИЦА ОШИБОК | МЕТРИКИ КЛАССИФИКАЦИИСкачать

Полнота

Полнота вычисляется путем деления числа правильно классифицированных положительных примеров (True Positive, TP) на общее число положительных примеров (True Positive + False Negative, TP + FN). Метрика полноты принимает значения от 0 до 1, где 1 означает идеальную полноту, а 0 — полное отсутствие полноты.

| Положительный класс | Отрицательный класс | |

|---|---|---|

| Предсказанный положительный | True Positive (TP) | False Positive (FP) |

| Предсказанный отрицательный | False Negative (FN) | True Negative (TN) |

Высокое значение полноты означает, что модель способна правильно идентифицировать большую долю положительных примеров из всех действительно положительных примеров. Однако, повышение полноты может привести к ухудшению других метрик, таких как точность или F-мера.

Метрика полноты особенно важна в случаях, когда пропуск даже одного положительного примера может иметь серьезные последствия. Например, в медицинских приложениях, где важно правильно определить наличие заболевания у пациента.

В случае, если полнота модели недостаточно высока, можно попытаться улучшить ее, используя различные подходы, например, изменение порогового значения классификации или подбор более подходящей модели.

Формула расчета полноты

Формула расчета полноты:

- True Positive (TP) — количество правильно классифицированных положительных объектов,

- False Negative (FN) — количество неправильно классифицированных положительных объектов.

Полнота вычисляется по следующей формуле:

Полнота = (TP) / (TP + FN)

Значение полноты может принимать значения от 0 до 1, где 1 представляет идеальный результат, означающий, что модель правильно классифицировала все положительные объекты.

Полнота является важным показателем в задачах, где существует нежелательный класс объектов, так как позволяет оценить, насколько хорошо модель находит этот класс.

Применение полноты в машинном обучении

Применение полноты имеет важное значение во множестве прикладных задач. Например, в медицине полнота может помочь выявить всех пациентов с определенным заболеванием, чтобы назначить им необходимое лечение. В кредитном скоринге полнота может помочь идентифицировать всех клиентов, которые реально имеют высокую вероятность возврата кредита, чтобы выдать им одобрение на получение кредита.

Однако, следует помнить, что при повышении полноты, часто наблюдается снижение точности модели. Это объясняется тем, что увеличение числа обнаруженных положительных примеров также приводит к возможному увеличению числа ложно-положительных результатов. Поэтому, в каждой конкретной задаче, необходимо находить баланс между полнотой и точностью, чтобы получить наиболее оптимальный результат.

Важно учитывать особенности конкретной задачи и ориентироваться на требования и предпочтения заказчика при выборе метрик для оценки моделей в машинном обучении. Использование полноты как метрики поможет достичь желаемых результатов в различных задачах классификации.

Видео:Основы машинного обучения, лекция 9 — метрики качества классификацииСкачать

F-мера

Для балансировки между точностью и полнотой, используется F-мера, которая является гармоническим средним между точностью и полнотой:

F-мера = 2 * (precision * recall) / (precision + recall)

Значение F-меры лежит в диапазоне от 0 до 1, где 1 означает идеальное значение, а 0 — наихудшее. Чем ближе значение F-меры к 1, тем лучше работает классификатор.

Применение F-меры особенно полезно в задачах, где важно то, чтобы и точность, и полнота были на высоком уровне. Например, в задаче выявления спама электронной почты, нам важно получить максимально точные результаты, чтобы не пропустить важные сообщения, но также важно минимизировать ложные срабатывания, чтобы не получать множество нежелательных писем.

Формула расчета F-меры

Формула для расчета F-меры выглядит следующим образом:

F = 2 * (точность * полнота) / (точность + полнота)

Где:

- Точность — это доля верно классифицированных объектов положительного класса относительно всех объектов, которые классификатор отнес к положительному классу.

- Полнота — это доля верно классифицированных объектов положительного класса относительно всех объектов, которые являются положительными.

Значение F-меры лежит в диапазоне от 0 до 1, где 1 — это идеальный результат, а 0 — плохой или неправильный результат. Чем ближе значение F-меры к 1, тем лучше качество классификатора.

Ф-мера является важной метрикой, которая учитывает и точность, и полноту, и, следовательно, позволяет оценить классификатор с учетом как ошибок первого рода (ложноположительных результатов), так и ошибок второго рода (ложноотрицательных результатов).

Применение F-меры в машинном обучении

Точность (precision) измеряет, как много объектов, отнесенных классификатором к положительному классу, являются действительно положительными. Полнота (recall) измеряет, как много из всех положительных объектов удалось обнаружить классификатору. Обе эти метрики важны, но иногда могут противоречить друг другу.

Например, классификатор может показывать высокую точность, но низкую полноту. Это значит, что он мало ошибается, но при этом упускает значительную часть положительных объектов. И наоборот, классификатор может показывать высокую полноту, но низкую точность, то есть он обнаруживает много положительных объектов, но среди них много ошибок.

Для оценки моделей классификации в таких ситуациях применяется F-мера. Она позволяет объединить информацию о точности и полноте в один показатель, который учитывает оба аспекта. F-мера вычисляется по следующей формуле:

F = (2 * точность * полнота) / (точность + полнота)

Значение F-меры лежит в диапазоне от 0 до 1, где 0 — самое плохое значение, а 1 — самое лучшее. Чем больше значение F-меры, тем более сбалансированной можно считать модель классификации.

Применение F-меры в машинном обучении позволяет выбрать наилучшую модель классификации, которая достигает наилучшего compromise между точностью и полнотой. Также F-мера полезна в задачах, где особенно важна идентификация обоих классов, как, например, в медицинских диагнозах, где ошибки могут иметь серьезные последствия.

Видео:Метрики машинного обученияСкачать

Дополнительные показатели метрик классификации

Помимо основных метрик классификации, существуют и другие показатели, которые могут быть полезными в анализе результатов модели.

1. Матрица ошибок (Confusion matrix)

| Предсказанные значения | ||

| Реальные значения | Положительный класс | Отрицательный класс |

| Истинно положительные (TP) | Ложно положительные (FP) | |

| Истинно отрицательные (TN) | Ложно отрицательные (FN) | |

Матрица ошибок позволяет наглядно представить результаты классификации, показывая количество правильно и неправильно классифицированных примеров. Из нее можно вычислить другие показатели, такие как точность, полноту, специфичность и F-меру.

2. Точность (Accuracy)

Точность определяется как доля правильно классифицированных примеров от общего числа примеров. Она не учитывает разбиение на классы, поэтому может быть неэффективной метрикой при несбалансированных данных.

3. Полнота (Recall)

Полнота определяет, какой процент примеров положительного класса был правильно классифицирован. Эта метрика важна в случаях, когда ложно отрицательные результаты недопустимы, например, при поиске раковых опухолей.

4. Специфичность (Specificity)

Специфичность показывает, какой процент примеров отрицательного класса был правильно классифицирован. Она полезна в случаях, когда ложно положительные результаты нежелательны, например, при тестировании на наличие инфекции.

5. F-мера (F1 score)

F-мера является гармоническим средним между точностью и полнотой. Эта метрика полезна для оценки классификаторов в случаях, когда речь идет о сбалансированном соотношении между точностью и полнотой.

Дополнительные показатели метрик классификации помогают глубже анализировать результаты работы модели и принимать информированные решения на основе этих данных.

Видео:#23. Показатели precision и recall. F-мера | Машинное обучениеСкачать

Матрица ошибок

Матрица ошибок представляет собой квадратную таблицу, в которой по горизонтали указаны фактические значения классов, а по вертикали — предсказанные значения классов. Каждая ячейка таблицы содержит количество примеров из тестовой выборки, которые относятся к определенной комбинации фактического и предсказанного классов.

В матрице ошибок выделяются четыре основных элемента:

- True Positive (TP) — число правильно классифицированных положительных примеров. Это ячейка в матрице, где фактический класс и предсказанный класс имеют значение «положительный».

- True Negative (TN) — число правильно классифицированных отрицательных примеров. Это ячейка в матрице, где фактический класс и предсказанный класс имеют значение «отрицательный».

- False Positive (FP) — число неправильно классифицированных примеров, которые были названы положительными. Это ошибка первого рода, когда модель ложно срабатывает и предсказывает положительный класс, в то время как фактический класс является отрицательным.

- False Negative (FN) — число неправильно классифицированных примеров, которые были названы отрицательными. Это ошибка второго рода, когда модель ложно отклоняет положительный класс, в то время как фактический класс является положительным.

На основе значений в матрице ошибок можно вычислить различные метрики классификации, такие как точность (accuracy), полнота (recall), специфичность (specificity) и F1-мера (F1-score). Также матрица ошибок может быть использована для анализа и исправления ошибок алгоритмов классификации.

Формула расчета матрицы ошибок

Формула для расчета матрицы ошибок зависит от типа задачи классификации (бинарной или многоклассовой) и количества классов, но обычно она имеет следующий вид:

Для бинарной классификации:

\[\begin{bmatrix}

TN & FP \\

FN & TP \\

\end{bmatrix}\]

Для многоклассовой классификации:

\[\begin{bmatrix}

C_{11} & C_{12} & \cdots & C_{1N} \\

C_{21} & C_{22} & \cdots & C_{2N} \\

\vdots & \vdots & \ddots & \vdots \\

C_{N1} & C_{N2} & \cdots & C_{NN} \\

\end{bmatrix}\]

Где:

- TN (True Negative) — количество верно классифицированных примеров отрицательного класса;

- FP (False Positive) — количество неверно классифицированных примеров отрицательного класса;

- FN (False Negative) — количество неверно классифицированных примеров положительного класса;

- TP (True Positive) — количество верно классифицированных примеров положительного класса;

- Cij — количество примеров класса i, которые были ошибочно предсказаны как класс j.

Матрица ошибок позволяет оценить различные характеристики работы классификатора, такие как точность (accuracy), полноту (recall), специфичность (specificity), точность (precision), мера F1 (F1-score) и другие.

Применение матрицы ошибок в машинном обучении

Применение матрицы ошибок позволяет оценить следующие метрики:

- Точность (accuracy) — отношение верно предсказанных объектов ко всем объектам. Данная метрика позволяет оценить общую эффективность модели.

- Полноту (recall) — отношение верно предсказанных объектов положительного класса к общему количеству объектов положительного класса. Полнота позволяет оценить, насколько модель успешно находит объекты положительного класса.

- Точность (precision) — отношение верно предсказанных объектов положительного класса к общему количеству объектов, которые модель предсказала как положительные. Точность позволяет оценить, насколько верно модель классифицирует объекты положительного класса.

- F-меру (F-measure) — гармоническое среднее между точностью и полнотой. Данная метрика позволяет оценить сбалансированность между точностью и полнотой модели.

Применение матрицы ошибок позволяет более детально проанализировать результаты классификации и выбрать наиболее подходящую модель. Кроме того, матрица ошибок может быть полезна для обнаружения специфических ошибок, которые модель делает при классификации определенных классов.

Видео:КЛАССИФИКАЦИЯ В МАШИННОМ ОБУЧЕНИИ на Python. ТОП-7 АЛГОРИТМОВ КЛАССИФИКАЦИИ. Алгоритмы на пальцах!Скачать

ROC-кривая и AUC-ROC

На ROC-кривой каждая точка соответствует определенному значению порога классификации и показывает, как модель справляется с различными значениями порога. Чем ближе точка к левому верхнему углу графика, тем лучше классификатор.

AUC-ROC (Area Under the ROC Curve) – это показатель, характеризующий качество модели классификации. AUC-ROC представляет собой площадь, ограниченную ROC-кривой и осью FPR. Значение AUC-ROC может варьироваться от 0 до 1, где 0 – худший классификатор, а 1 – идеальный классификатор.

Чем выше значение AUC-ROC, тем лучше качество модели. AUC-ROC можно использовать для сравнения различных моделей между собой и выбора наилучшей из них. Также AUC-ROC может быть полезен в случаях, когда классы несбалансированы.

Использование ROC-кривой и AUC-ROC позволяет более объективно оценить модель классификации и принять взвешенное решение на основе её качества.

Формула расчета ROC-кривой и AUC-ROC

Формула для расчета TPR и FPR в зависимости от порогового значения задается следующим образом:

TPR = TP / (TP + FN)

FPR = FP / (FP + TN)

где:

TP — число верно классифицированных объектов положительного класса (True Positives);

FN — число неверно классифицированных объектов положительного класса (False Negatives);

FP — число неверно классифицированных объектов отрицательного класса (False Positives);

TN — число верно классифицированных объектов отрицательного класса (True Negatives).

ROC-кривая строится путем изменения порогового значения и вычисления соответствующих значений TPR и FPR для каждого порога.

AUC-ROC (Area Under the ROC Curve) представляет собой площадь, заключенную под ROC-кривой, и является мерой качества классификатора. Чем ближе значение AUC-ROC к 1, тем лучше работает классификатор. Значение AUC-ROC равное 0.5 говорит о случайном прогнозировании.

Расчет AUC-ROC осуществляется путем интегрирования под кривой ROC с использованием различных методов, таких как метод трапеций.

Применение ROC-кривой и AUC-ROC в машинном обучении

ROC-кривая графически отображает зависимость между чувствительностью (True Positive Rate) и специфичностью (False Positive Rate) классификатора при различных порогах классификации. Здесь чувствительность показывает уровень правильно определенных положительных классов, а специфичность описывает уровень правильно определенных отрицательных классов.

AUC-ROC представляет собой площадь, ограниченную ROC-кривой и осью FPR (ось специфичности). Этот показатель предоставляет информацию о вероятности того, что классификатор будет правильно классифицировать случайно выбранный положительный объект выше, чем случайно выбранный отрицательный объект. Чем выше значение AUC-ROC, тем лучше модель классификации.

Применение ROC-кривой и AUC-ROC в машинном обучении позволяет сравнивать и выбирать наилучшую модель классификации из нескольких вариантов. Кривая позволяет визуализировать эффективность классификатора, а площадь под ней дает количественную оценку качества модели. Эти метрики также позволяют анализировать чувствительность и специфичность классификатора для различных порогов.

ROC-кривую и AUC-ROC можно применять в различных задачах машинного обучения, таких как медицинская диагностика, распознавание образов, анализ текстов и др. Они обеспечивают универсальный и надежный способ оценки качества классификационных моделей и помогают принимать решения на основе полученных результатов.

В итоге, применение ROC-кривой и AUC-ROC в машинном обучении играет важную роль в оценке и выборе лучшей модели классификации, а также позволяет получить информацию о чувствительности и специфичности классификатора.

Видео:МЕТРИКИ РЕГРЕССИИ В МАШИННОМ ОБУЧЕНИИ | MAE, MSE, RMSE, R2, коэффициент детерминации.Скачать

Интерпретация результатов метрик классификации

Одной из основных метрик является точность (accuracy). Она показывает долю правильно классифицированных объектов относительно общего числа объектов. Чем выше точность, тем лучше работает классификатор.

Помимо точности и матрицы ошибок, существуют и другие метрики, такие как полнота (recall), точность (precision), F-мера (F-measure) и др. Каждая из них отражает важные аспекты работы модели, такие как способность правильно классифицировать положительные и отрицательные объекты, соотношение ложных срабатываний и ложных пропусков.

Интерпретация результатов метрик классификации позволяет понять, насколько эффективно модель классификации решает задачу, а также выявить ее сильные и слабые стороны. Например, если модель имеет высокую точность, но низкую полноту, это может говорить о том, что она хорошо предсказывает один класс, но слабо предсказывает другой.

Видео:#6. Решение простой задачи бинарной классификации | Машинное обучениеСкачать

Оценка качества модели по метрикам классификации

Одной из основных метрик классификации является точность (accuracy). Она определяет долю правильно классифицированных объектов относительно общего числа объектов. Точность позволяет оценить общую эффективность алгоритма и является одним из наиболее интуитивно понятных показателей.

Однако, точность не всегда является достаточным показателем для оценки качества модели. Например, в задачах, где классы несбалансированы, высокая точность может быть обусловлена неверно классифицированными объектами меньшего класса, тогда как объекты более крупного класса могли быть неправильно классифицированы.

При оценке модели машинного обучения также важно учитывать полноту (recall) и точность (precision). Полнота определяет долю объектов положительного класса, которые были правильно классифицированы. Точность определяет долю объектов, которые были правильно классифицированы как положительные относительно всех объектов, классифицированных как положительные.

Для более полной оценки качества модели используется F-мера (F-measure), которая является гармоническим средним между полнотой и точностью. F-мера учитывает как полноту, так и точность, и является более устойчивым показателем в случае несбалансированных классов.

Кроме того, для оценки качества модели могут использоваться матрица ошибок (confusion matrix), ROC-кривая и показатель AUC-ROC. Матрица ошибок позволяет наглядно представить результаты классификации, отображая количество верно и неверно классифицированных объектов каждого класса. ROC-кривая и AUC-ROC позволяют оценить способность модели отличать положительные и отрицательные классы и являются важными инструментами при выборе порогового значения.

Видео:Основы машинного обучения, лекция 9 — метрики качества классификацииСкачать

Сравнение моделей на основе метрик классификации

Одной из самых популярных метрик является точность (accuracy) – отношение числа правильно классифицированных объектов к общему числу объектов. Однако эта метрика может быть введена в заблуждение в случае несбалансированных классов, когда один класс преобладает над другими.

Для сбалансированной оценки метрик классификации рекомендуется использовать матрицу ошибок (confusion matrix). Она позволяет рассчитать такие метрики, как точность (precision), полнота (recall) и F-мера (F1-score). Точность показывает, насколько точно модель идентифицирует положительные объекты, полнота – насколько полно идентифицируются положительные объекты, а F-мера – их гармоническое среднее.

В зависимости от задачи, иногда важнее максимизировать точность, а в других случаях – полноту. Поэтому сравнение моделей на основе метрик классификации должно учитывать специфику задачи и поставленные требования.

- Если важно минимизировать ложноположительные результаты (когда модель неправильно классифицирует положительные объекты),то следует рассматривать модель с высокой точностью.

- Если необходимо минимизировать ложноотрицательные результаты (когда модель пропускает положительные объекты), то следует рассматривать модель с высокой полнотой.

- Если нужна компромиссная модель, которая дает приемлемый баланс между точностью и полнотой,то стоит обратить внимание на F-меру.

Важно также отметить, что в сравнении моделей на основе метрик классификации нужно учитывать другие факторы, такие как интерпретируемость модели, сложность, скорость обучения и предсказания, а также возможность обработки несбалансированных данных.

Таким образом, сравнение моделей на основе метрик классификации позволяет оценить и выбрать оптимальную модель для решения задачи классификации, удовлетворяющую поставленным требованиям и контексту задачи.

💥 Видео

#7. Функции потерь в задачах линейной бинарной классификации | Машинное обучениеСкачать

Разделение Данных и Метрики || Машинное ОбучениеСкачать

#24. Метрики качества ранжирования. ROC-кривая | Машинное обучениеСкачать

Метрики в задачах регрессии. MSE, MAE, MSLE. Машинное обучениеСкачать

#29. Метрические методы классификации. Метод k ближайших соседей | Машинное обучениеСкачать

Машинное обучение. Лекция 6. Метрики качества бинарной классификацииСкачать