При обучении алгоритма классификации существует множество методов и способов, которые позволяют улучшить его результаты и повысить точность предсказаний. Такие дополнения к алгоритму могут быть полезными в различных областях, таких как медицина, финансы, маркетинг и другие.

Одним из распространенных методов дополнения алгоритма является введение дополнительных признаков или фичей. Дополнительные признаки могут быть получены из исходных данных путем их преобразования или комбинации. Например, в задаче классификации покупателей, можно добавить дополнительные признаки, такие как общая сумма покупок или длительность клиентского отношения с компанией. Это помогает учесть дополнительную информацию и повысить качество классификации.

Еще одним методом дополнения является применение ансамблей алгоритмов. Ансамбль представляет собой объединение нескольких моделей классификации в одну итоговую модель. При использовании ансамблей, каждая модель предсказывает класс отдельно, а затем результаты объединяются в общий результат. Такой подход позволяет улучшить стабильность и устойчивость работы алгоритма, поскольку он основывается на совместном предсказании нескольких независимых моделей.

Также можно использовать различные методы взвешивания классов в алгоритме классификации. В некоторых задачах классы могут быть несбалансированными, что может привести к неравномерности предсказаний. Для решения этой проблемы можно применить методы взвешивания, которые устанавливают разные веса для каждого класса в зависимости от его важности. Такой подход позволяет улучшить точность предсказания в задачах с несбалансированными классами.

- Дополнения к алгоритму обучения классификации

- Методы и способы расширения алгоритма

- Увеличение размерности признакового пространства

- Применение ансамблевых моделей

- Методы и способы снижения ошибок классификации

- Взвешивание классов

- Использование алгоритмов обучения с подкреплением

- Методы и способы улучшения обобщающей способности модели

- Регуляризация

- Управление сложностью модели

- Методы и способы учета особенностей классифицируемых данных

- Обработка несбалансированных выборок

- Учет категориальных признаков

- Методы и способы учета зависимостей между признаками

- Методы отбора признаков

- Применение методов генерации новых признаков

- Методы и способы быстрого обучения классификатора

- 1. Разделение данных на тренировочную и тестовую выборки

- 2. Использование алгоритмов снижения размерности

- 3. Параллельное обучение классификатора

- 4. Использование алгоритмов с ускоренным обучением

- Применение методов стохастического градиентного спуска

- Использование аппроксимаций при вычислениях

- 🔍 Видео

Видео:Ансамблевые методы: стекинг, беггинг и бустингСкачать

Дополнения к алгоритму обучения классификации

В процессе обучения классификации широко используются различные алгоритмы и методы. Однако, иногда стандартные алгоритмы не дают достаточно точных результатов или не способны решить сложные задачи классификации. В таких случаях можно применять дополнения к основному алгоритму обучения для достижения лучших результатов.

Одним из дополнений к алгоритму обучения классификации является использование ансамблевых методов. Ансамблевые методы объединяют несколько алгоритмов в единый классификатор, которые работают совместно для принятия решений. Примерами ансамблевых методов являются бэггинг, бустинг и случайный лес. Эти методы позволяют улучшить показатели классификации за счет объединения предсказаний нескольких алгоритмов.

Другим дополнением к алгоритму обучения классификации является использование метода генерации новых признаков. Этот метод позволяет создавать новые признаки на основе имеющихся данных. Новые признаки могут быть получены путем комбинирования или преобразования существующих признаков. Это позволяет улучшить представление данных и повысить точность классификатора.

Также существуют методы регуляризации, которые помогают бороться с проблемой переобучения. Путем добавления штрафных членов к функционалу алгоритма, методы регуляризации ограничивают свободы модели и делают ее более устойчивой к шумам и перекрываниям классов. Примерами методов регуляризации являются L1-регуляризация и L2-регуляризация.

Таким образом, дополнения к алгоритму обучения классификации позволяют улучшить его точность и способность решать сложные задачи классификации. Использование ансамблевых методов, генерации новых признаков и методов регуляризации является эффективным подходом к повышению качества классификации и расширению возможностей алгоритма.

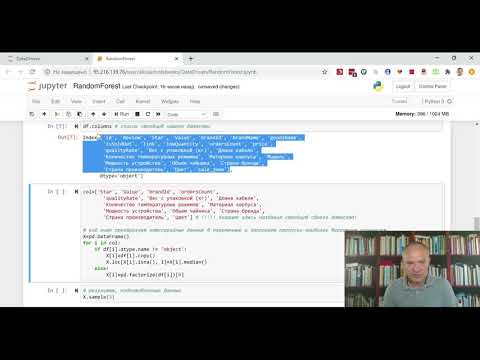

Видео:RandomForest - очень просто о том, как использовать классификацию в PythonСкачать

Методы и способы расширения алгоритма

Один из методов расширения алгоритма классификации — это использование ансамблей моделей. Ансамбли состоят из нескольких базовых моделей, которые применяются одновременно для получения более точных предсказаний. Например, можно использовать метод случайного леса, где несколько деревьев решений объединяются для принятия решения.

Еще одним способом расширения алгоритма является использование предварительной обработки данных. Это может включать в себя стандартизацию или нормализацию значений признаков, преобразование категориальных признаков в числовые, или удаление выбросов. Предварительная обработка данных позволяет улучшить качество классификации и облегчить работу алгоритма на конкретных типах данных.

Еще одним методом расширения алгоритма является введение новых признаков. Это может быть результатом объединения нескольких имеющихся признаков или создания новых на основе существующих. Новые признаки могут улучшить разделяющую способность алгоритма и помочь ему делать более точные прогнозы.

Также можно использовать различные методы регуляризации для улучшения алгоритма. Регуляризация позволяет уменьшить переобучение модели и сделать ее более устойчивой к шуму и аномалиям в данных. К некоторым из методов регуляризации относятся L1 и L2 регуляризация, а также Dropout.

Еще одним примером расширения алгоритма является использование весов классов. В случаях, когда классы несбалансированы, значит один класс встречается значительно чаще или реже, чем другие, можно применить взвешивание классов. Это позволяет алгоритму учесть эти различия и дать более сбалансированные предсказания.

Увеличение размерности признакового пространства

Одним из преимуществ увеличения размерности признакового пространства является улучшение разделимости классов. Дополнительные признаки могут помочь классификатору лучше определить границы между классами и более точно отнести новые объекты к нужным классам.

Существует несколько методов увеличения размерности признакового пространства, таких как:

- Полиномиальные признаки: дополнительные признаки получаются путем возведения существующих признаков в степени. Это помогает выявить нелинейные зависимости между признаками.

- Взаимодействия: новые признаки создаются путем комбинирования уже существующих признаков. Например, можно вычислить произведение или разность между значениями двух признаков.

- Гауссовы признаки: новые признаки создаются на основе нормального распределения. Это может помочь учесть более сложные зависимости между признаками.

Выбор конкретного метода увеличения размерности признакового пространства зависит от данных и задачи классификации. Некоторые методы могут быть более эффективными для определенных типов данных или для решения конкретных задач.

Однако, необходимо учитывать, что увеличение размерности признакового пространства может привести к увеличению вычислительной сложности и переобучению модели. Поэтому необходимо внимательно подходить к выбору метода и контролировать процесс увеличения размерности.

Важно отметить, что увеличение размерности признакового пространства не всегда означает улучшение результатов. Необходимо провести тщательный анализ данных и эксперименты для оценки эффективности метода увеличения размерности. В некоторых случаях более сложные модели могут привести к ухудшению результатов.

Применение ансамблевых моделей

Применение ансамблевых моделей стало популярным в машинном обучении в связи с их способностью превзойти предельные результаты отдельных моделей. Ансамбли моделей могут применяться в различных задачах классификации, таких как обработка изображений, распознавание речи, анализ текста, рекомендательные системы и т.д.

Существует несколько видов ансамблевых моделей, включая:

- Бэггинг (bagging): этот метод основан на использовании нескольких независимых моделей, которые обучаются на различных подмножествах обучающих данных, а затем их результаты усредняются;

- Бустинг (boosting): основная идея заключается в построении нескольких слабых моделей и их последовательном улучшении с учетом ошибок, допущенных предыдущими моделями;

- Случайные леса (random forests): метод комбинирует несколько деревьев решений, которые обучаются на различных подмножествах признаков и данных, для получения окончательного решения.

Преимущества ансамблевых моделей включают повышение точности классификации, устойчивость к переобучению, способность обрабатывать большие объемы данных и улучшение обобщающей способности модели.

Видео:КЛАССИФИКАЦИЯ В МАШИННОМ ОБУЧЕНИИ на Python. ТОП-7 АЛГОРИТМОВ КЛАССИФИКАЦИИ на Практике!Скачать

Методы и способы снижения ошибок классификации

1. Подбор оптимальных признаков. Алгоритмы классификации основываются на выбранных признаках для принятия решений. Подбор оптимальных признаков позволяет исключить нерелевантные и шумовые признаки, что помогает улучшить качество классификации.

2. Расширение обучающей выборки. Увеличение размера обучающей выборки может помочь алгоритму более точно оценить границы разделения классов и снизить вероятность ошибок.

3. Использование ансамблевых методов. Ансамблевые методы объединяют несколько алгоритмов классификации для получения более точных результатов. Поскольку каждый алгоритм может допускать свои ошибки, совместное решение нескольких алгоритмов позволяет снизить вероятность ошибочной классификации.

4. Регуляризация. Регуляризация – это метод, который добавляет штраф к функции потерь, чтобы предотвратить переобучение модели. Ограничение сложности модели позволяет снизить ошибку на тестовой выборке.

5. Использование кросс-валидации. Кросс-валидация – это метод оценки производительности модели с использованием разных обучающих и тестовых подмножеств. Это позволяет получить более объективную оценку эффективности классификации и снизить вероятность переобучения.

Все эти методы и способы работают вместе для снижения ошибок классификации и повышения точности алгоритмов. Их использование зависит от конкретной задачи и данных, но все они направлены на достижение наилучшего качества классификации.

Взвешивание классов

В обучении классификации иногда бывает необходимо учесть неравенство распределения классов или повысить важность определенных классов. Для этого используется техника, называемая взвешивание классов.

Взвешивание классов позволяет корректировать веса классов в алгоритме обучения так, чтобы классы с меньшим количеством экземпляров получали больший вклад в процесс обучения. Это позволяет учесть дисбаланс классов и повысить точность предсказаний для меньшего класса.

Существуют разные подходы к взвешиванию классов. Один из них — использование весов, пропорциональных обратным частотам классов. То есть, чем меньше экземпляров класса в обучающем наборе данных, тем больший вес получает этот класс. Это позволяет алгоритму обучения уделять больше внимания меньшему классу.

Еще один подход заключается в использовании весов, задаваемых вручную. Этот подход позволяет настраивать веса классов в зависимости от требований и особенностей задачи. Например, если один класс важнее другого с точки зрения приоритета, можно задать больший вес для этого класса.

Взвешивание классов полезно при работе с дисбалансированными данными, когда один класс является преобладающим, а другой — редким. Это позволяет улучшить качество модели и получить более сбалансированные предсказания для разных классов.

Использование алгоритмов обучения с подкреплением

В отличие от алгоритмов обучения с учителем, где для каждого примера известны правильные ответы, и алгоритмов обучения без учителя, где примеры не имеют меток классов, алгоритмы обучения с подкреплением основываются на предоставлении агенту только обратной связи в виде награды или штрафа за выполнение определенных действий.

Агент взаимодействует с окружающей средой, выбирает определенные действия и получает награду или штраф в зависимости от результата своих действий. Целью агента является максимизация награды, что может быть достигнуто путем выбора оптимальных действий в каждой ситуации.

Одним из наиболее известных алгоритмов обучения с подкреплением является Q-обучение. В этом алгоритме агент поддерживает таблицу значений Q, в которой хранятся оценки каждой пары состояние-действие. Агент обновляет значения Q в процессе взаимодействия с окружающей средой, используя формулу обновления на основе полученной награды и оценки значения Q для следующего состояния.

Другим популярным алгоритмом обучения с подкреплением является поиск с использованием эволюционных стратегий. В этом алгоритме агент не обновляет оценки Q, а вместо этого применяет мутации и селекцию, чтобы улучшить свои действия. Агент исполняет некоторое количество испытаний, оценивает полученную награду и выбирает лучшие действия для следующих испытаний.

Таким образом, использование алгоритмов обучения с подкреплением позволяет агенту эффективно учиться взаимодействовать с окружающей средой и принимать оптимальные решения для достижения поставленных целей.

Видео:#28. Многоклассовая классификация. Методы one-vs-all и all-vs-all | Машинное обучениеСкачать

Методы и способы улучшения обобщающей способности модели

- Регуляризация: Регуляризация позволяет управлять сложностью модели и предотвращать переобучение. Этот метод добавляет к функции потерь штрафное слагаемое, которое учитывает сложность модели. Таким образом, модель стремится найти баланс между точностью предсказаний и сложностью модели.

- Выборка данных: При обучении модели важно правильно подобрать и использовать данные для обучения. Недостаточное количество данных может привести к недообучению модели, а слишком большой объем данных может привести к переобучению. Поэтому необходимо тщательно подбирать и разделить данные на обучающую, валидационную и тестовую выборки.

- Аугментация данных: Аугментация данных является методом, при котором к имеющейся обучающей выборке добавляются немного измененные копии изображений или примеров данных. Это позволяет расширить обучающую выборку и улучшить устойчивость модели к различным вариациям данных.

- Использование ансамблей моделей: Ансамбли моделей объединяют предсказания нескольких моделей для получения более точных результатов. Различные модели могут иметь различные слабости и сильные стороны, поэтому комбинирование их предсказаний может улучшить обобщающую способность модели.

- Кросс-валидация: Кросс-валидация позволяет оценить обобщающую способность модели путем последовательного разделения данных на обучающую и валидационную выборки. Этот метод позволяет оценить модель на различных подмножествах данных и получить более надежные оценки качества модели.

Комбинация различных методов и способов может помочь улучшить обобщающую способность модели и повысить ее предсказательную точность на новых данных. Важно выбирать и применять подходящие методы, учитывая специфику задачи и доступные ресурсы.

Регуляризация

Одним из способов регуляризации является L1-регуляризация, которая добавляет штраф к функции потерь, равный сумме модулей весов модели. Такой подход позволяет понизить веса некоторых признаков до нуля, что соответствует отбору наиболее важных признаков.

Другим методом является L2-регуляризация, которая добавляет к функции потерь штраф, равный сумме квадратов весов модели. Это позволяет снизить влияние больших весов и стабилизировать обучение модели.

Также существуют комбинированные методы регуляризации, например, Elastic Net, который сочетает в себе L1- и L2-регуляризацию. Он позволяет находить баланс между отбором признаков и снижением весов.

Регуляризация является важной и эффективной техникой, которая помогает бороться с переобучением модели и повышает ее обобщающую способность.

Управление сложностью модели

При построении модели машинного обучения важно найти баланс между точностью предсказания и сложностью модели. Чрезмерно сложная модель может привести к переобучению, тогда как слишком простая модель может недостаточно точно предсказывать результаты. Управление сложностью модели позволяет найти оптимальный баланс между этими двумя аспектами.

Существует несколько методов и способов, которые позволяют управлять сложностью модели:

| Метод | Описание |

|---|---|

| Регуляризация | Регуляризация добавляет штраф к функции потерь модели для предотвращения переобучения. Популярные методы регуляризации включают L1-регуляризацию, L2-регуляризацию и ElasticNet-регуляризацию. |

| Отбор признаков | Отбор признаков позволяет удалять ненужные или коррелирующие признаки из модели. Это позволяет снизить сложность модели и улучшить ее обобщающую способность. |

| Понижение размерности | Понижение размерности позволяет уменьшить количество признаков путем проецирования данных на новое пространство меньшей размерности. Это помогает снизить сложность модели и улучшить ее производительность. |

| Ensemble-методы | Ensemble-методы комбинируют несколько моделей в одну для улучшения качества предсказаний. Это позволяет уменьшить смещение и разброс модели, что помогает снизить сложность и повысить стабильность. |

Выбор подходящего метода или нескольких методов для управления сложностью модели зависит от конкретной задачи и данных, на которых проводится обучение. Комбинация различных методов позволяет достичь оптимального баланса между точностью и сложностью модели.

Видео:Классическое машинное обучение: популярные методы и алгоритмыСкачать

Методы и способы учета особенностей классифицируемых данных

При проведении классификации данных важно учитывать особенности самих данных. Некоторые методы классификации требуют определенной предобработки данных или учета их специфики.

1. Нормализация данных. Одним из способов учета особенностей данных является их нормализация. Нормализация данных позволяет привести все признаки к одному диапазону значений, что позволяет более корректно и справедливо оценить их влияние на классификацию.

2. Работа с выбросами. Классификация данных может быть затруднена наличием выбросов – значений, которые выбиваются из общей картины искомого класса. Для учета этой особенности можно использовать различные методы поиска и удаления выбросов или их корректной обработки в процессе классификации.

3. Учет дисбаланса классов. Когда классы данных несбалансированы по количеству примеров, это может существенно влиять на качество классификации. В таких случаях полезными методами являются взвешивание экземпляров классов или использование специальных алгоритмов обучения, которые более чувствительны к меньшему классу.

4. Использование дополнительных признаков. В некоторых случаях бывает полезно создание новых признаков, которые могут содержать дополнительную информацию для классификации. Например, при работе с текстовыми данными можно создать признаки на основе частотности слов или N-грамм.

5. Учет зависимостей между признаками. Для некоторых методов классификации важна корректная оценка зависимостей между признаками. Например, при использовании наивного Байеса предполагается независимость признаков, поэтому необходимо учесть это в процессе подготовки данных.

6. Аугментация данных. Аугментация данных – это метод, при помощи которого в обучающую выборку добавляются модифицированные версии существующих данных. Это может быть полезно, если данных недостаточно для тренировки модели или если требуется учет различных искажений, таких как повороты, масштабирование, добавление шума и другие.

Важно подбирать и применять методы и способы учета особенностей классифицируемых данных согласно конкретной задаче и используемому алгоритму классификации. Это позволит повысить качество классификации и достичь более точных результатов.

Обработка несбалансированных выборок

Для решения проблемы несбалансированных выборок существует несколько подходов:

- Изменение весов объектов — этот метод заключается в изменении весов объектов в выборке. Объекты из миноритарного класса получают больший вес, тем самым повышая их значимость при обучении модели.

- Искусственное увеличение миноритарного класса — в этом подходе используется метод генерации новых объектов из миноритарного класса. Новые объекты добавляются в выборку, тем самым уравновешивая количество объектов в обоих классах.

- Искусственное уменьшение мажоритарного класса — в данном случае происходит удаление части объектов из мажоритарного класса. Это позволяет снизить количество объектов в мажоритарном классе и, таким образом, сбалансировать выборку.

- Комбинированные подходы — часто используется комбинация разных методов для более эффективной обработки несбалансированных выборок. Например, сначала происходит искусственное увеличение миноритарного класса, а затем изменение весов объектов.

Обработка несбалансированных выборок позволяет улучшить качество классификации и сделать ее более справедливой для обоих классов. Выбор конкретного метода зависит от специфики данных и требований задачи.

Учет категориальных признаков

Категориальные признаки представляют собой значения из ограниченного набора категорий или классов. Примерами таких признаков могут быть пол, цвет, род занятий и т.д. В отличие от количественных признаков, которые имеют числовую или непрерывную характеристику, категориальные признаки требуют особого подхода при их обработке в алгоритмах машинного обучения.

Одним из способов учета категориальных признаков является преобразование их в числовой формат. Для этого можно использовать метод кодирования, такой как Label Encoding или One-Hot Encoding. В методе Label Encoding каждой категории присваивается уникальное число. Например, если у нас есть признак «Цвет» с категориями «Красный», «Зеленый», «Синий», то этим категориям могут быть присвоены числа 1, 2 и 3 соответственно. Однако, при использовании Label Encoding может возникнуть проблема, когда алгоритмы машинного обучения будут интерпретировать эти числа как порядковые значения. Для того чтобы избежать этой проблемы, можно использовать One-Hot Encoding. В этом методе каждая категория представляется в виде бинарного вектора, состоящего из нулей и одной единицы. Например, для признака «Цвет» и категории «Красный», «Зеленый», «Синий» будут созданы три бинарных признака: «Цвет_Красный», «Цвет_Зеленый» и «Цвет_Синий». Значение каждого признака будет равно 1, если категория соответствует данному признаку, и 0 в противном случае.

Еще одним методом учета категориальных признаков является метод Target Encoding. В этом методе каждой категории присваивается вероятность принадлежности к каждому классу, основываясь на распределении целевой переменной для данной категории. Например, если у нас есть категория «Красный» и целевая переменная «Класс», то мы можем вычислить вероятность принадлежности к классу для этой категории. Затем, эту вероятность можно использовать в качестве числового признака для обучения модели.

Кроме того, существуют и другие методы обработки категориальных признаков, такие как Binary Encoding, BaseN Encoding и другие. Они подходят для различных ситуаций и имеют свои преимущества и недостатки. Выбор метода зависит от конкретной задачи и особенностей данных.

| Метод | Описание |

|---|---|

| Label Encoding | Присваивание уникального числа каждой категории |

| One-Hot Encoding | Преобразование категорий в бинарные признаки |

| Target Encoding | Присваивание вероятности категории на основе целевой переменной |

Учет категориальных признаков является важной частью обучения моделей классификации. Правильное преобразование и эффективная обработка категориальных признаков помогают улучшить результаты предсказания и повысить качество моделей.

Видео:Метод К-Ближайших Соседей (KNN) || Введение в Машинное Обучение и Data ScienceСкачать

Методы и способы учета зависимостей между признаками

При разработке алгоритмов классификации часто возникает проблема учета зависимостей между признаками. Зависимости между признаками могут быть положительные или отрицательные, линейные или нелинейные, явные или скрытые. Учет зависимостей между признаками позволяет улучшить качество классификации и предсказательную способность модели.

Одним из методов учета зависимостей между признаками является использование полиномиальных признаков. Этот метод позволяет моделировать нелинейные зависимости между признаками путем создания новых признаков, которые являются произведениями степеней исходных признаков. Например, если у нас есть признаки x и y, то мы можем добавить новые признаки x^2, x*y и y^2, чтобы учесть возможные нелинейные зависимости.

Другим способом учета зависимостей между признаками является использование группировки признаков. Этот метод позволяет объединить несколько признаков в один новый признак, который будет учитывать зависимость между исходными признаками. Например, если у нас есть признаки x1, x2 и x3, которые представляют различные характеристики объекта, то мы можем создать новый признак x4, который будет являться средним значением этих трех признаков.

Кроме того, можно использовать методы выбора признаков, которые позволяют определить наиболее информативные признаки, учитывая их зависимости друг от друга. Это позволяет уменьшить размерность пространства признаков и улучшить скорость работы алгоритма. Один из таких методов — метод главных компонент (Principal Component Analysis), который основывается на поиске линейных комбинаций исходных признаков с наибольшей дисперсией.

Важно отметить, что выбор конкретных методов и способов учета зависимостей между признаками зависит от конкретной задачи и типа данных. Не всегда все методы будут эффективны и применимы. Поэтому важно провести анализ данных и эксперименты, чтобы определить наиболее подходящий метод для конкретной задачи классификации.

Методы отбора признаков

Существует несколько методов отбора признаков, которые могут быть использованы в алгоритме обучения классификации:

- Метод корреляции – позволяет исключить признаки, имеющие высокую корреляцию с другими признаками. Это помогает избежать мультиколлинеарности и улучшить обобщающую способность модели.

- Метод информативности – основывается на измерении важности признаков с помощью различных статистических метрик, таких как взаимная информация или энтропия. Признаки с высокой информативностью считаются более значимыми.

- Метод регуляризации – использует регуляризацию для штрафования признаков с большими значениями весов. Это помогает уменьшить эффект переобучения и повысить устойчивость модели к шуму.

- Метод вложений – строит модель классификации, включающую отбор признаков как часть оптимизации. Это позволяет автоматически определить наиболее важные признаки для конкретной задачи.

- Метод статистических тестов – основывается на проведении статистических тестов для оценки значимости признаков. Наиболее популярными статистическими тестами для отбора признаков являются t-тест и анализ дисперсии (ANOVA).

Выбор конкретного метода отбора признаков зависит от характеристик данных и постановки задачи классификации. Комбинация различных методов может дать лучший результат в плане точности классификации, интерпретируемости модели и скорости обучения.

Применение методов генерации новых признаков

Дополнения алгоритма обучения классификации могут включать в себя методы и способы генерации новых признаков, которые помогают улучшить качество предсказаний модели. Генерация новых признаков основана на использовании имеющихся данных и преобразовании их в новые представления, которые могут быть более информативными для модели.

Применение методов генерации новых признаков может быть полезно в следующих случаях:

- Наличие нескольких наборов исходных данных. В этом случае можно объединить эти наборы и добавить новые признаки, которые будут отражать связь между разными наборами данных.

- Отсутствие важной информации в исходных признаках. В этом случае можно использовать существующие признаки для генерации новых, которые будут более информативными и позволят модели лучше распознавать паттерны в данных.

- Присутствие неоднозначной информации. В этом случае можно использовать методы генерации новых признаков для уточнения и конкретизации информации, что также может улучшить предсказательные возможности модели.

Существует множество методов генерации новых признаков, включая:

- Добавление полиномиальных признаков. Этот метод заключается в возведении исходных признаков в степень, чтобы учесть нелинейные зависимости между ними.

- Преобразование категориальных признаков в числовые. Этот метод заключается в преобразовании категориальных признаков в числовые с помощью различных кодировок (например, one-hot encoding или label encoding).

- Использование дискретизации признаков. Этот метод заключается в разбиении числовых признаков на дискретные интервалы, что может помочь уловить определенные закономерности в данных.

- Применение агрегирования признаков. Этот метод заключается в объединении нескольких признаков в один путем вычисления их статистических характеристик (например, среднее, максимум или минимум).

Применение методов генерации новых признаков может значительно улучшить способность модели к классификации данных, что позволяет получить более точные и надежные результаты. При использовании этих методов важно учитывать особенности исходных данных и задачи классификации, чтобы выбрать наиболее подходящие методы и способы генерации новых признаков.

Видео:Алгоритм k-ближайших соседей // Основы машинного обученияСкачать

Методы и способы быстрого обучения классификатора

1. Разделение данных на тренировочную и тестовую выборки

Один из способов быстрого обучения классификатора — это разделение данных на тренировочную и тестовую выборки. Такой подход позволяет использовать только часть данных для обучения, что значительно сокращает время обработки. При этом результаты обучения на тестовой выборке становятся менее точными, но при достаточно большом объеме данных это снижение точности может быть незначительным.

2. Использование алгоритмов снижения размерности

Другим способом ускорения обучения классификатора является применение алгоритмов снижения размерности данных. Такие алгоритмы позволяют уменьшить количество признаков, которые используются для обучения классификатора, при этом сохраняя основную информацию. Меньшее количество признаков упрощает задачу обучения и позволяет ускорить работу классификатора.

3. Параллельное обучение классификатора

Еще одним методом быстрого обучения классификатора является его параллельное обучение. Это означает, что обучение классификатора происходит одновременно на нескольких процессорах или ядрах. Такой подход позволяет увеличить скорость обучения, а также использовать больше данных для обучения.

4. Использование алгоритмов с ускоренным обучением

Некоторые алгоритмы классификации имеют специальные реализации с ускоренным обучением. Такие алгоритмы используют различные техники, такие как предобработка данных, оптимизация алгоритма и др., чтобы ускорить процесс обучения. Использование таких алгоритмов позволяет значительно сократить время, затрачиваемое на обучение классификатора.

| Метод/способ | Преимущества | Недостатки |

|---|---|---|

| Разделение данных на тренировочную и тестовую выборки | Сокращение времени обучения | Снижение точности на тестовой выборке |

| Использование алгоритмов снижения размерности | Уменьшение количества признаков | Потеря некоторой информации |

| Параллельное обучение классификатора | Увеличение скорости обучения | Необходимость наличия нескольких процессоров/ядер |

| Использование алгоритмов с ускоренным обучением | Сокращение времени обучения | Зависимость от специальной реализации алгоритма |

Использование этих методов и способов позволяет существенно ускорить обучение классификатора и получить результаты в более короткие сроки. Выбор конкретного метода зависит от поставленных задач и требований к скорости и точности классификации.

Применение методов стохастического градиентного спуска

Методы стохастического градиентного спуска (Stochastic Gradient Descent, SGD) широко применяются в задачах классификации. Эти методы позволяют обучить модель на больших объемах данных с более высокой скоростью.

Преимущество методов SGD заключается в том, что они основываются на локальных градиентах, применяемых к случайно выбранным подмножествам данных (mini-batch), вместо вычисления градиента по всему набору данных, как в случае обычного градиентного спуска. Это позволяет ускорить процесс обучения и обработки больших данных.

Вместо того, чтобы обновлять веса модели для каждого примера в наборе данных, как в методе SGD, методы стохастического градиентного спуска работают с небольшими подмножествами данных, что позволяет учесть шум и вариативность в данных. Это особенно полезно, когда данные имеют большое количество выбросов или шумов.

Применение методов стохастического градиентного спуска позволяет достичь высокой скорости сходимости, а также лучшей обобщающей способности модели. Возможность работать с большими объемами данных делает эти методы неотъемлемой частью машинного обучения и алгоритмов классификации.

Использование аппроксимаций при вычислениях

Методы искусственного интеллекта, включая алгоритмы классификации, часто требуют больших вычислительных мощностей для достижения точных результатов. Однако, в реальных приложениях может возникнуть необходимость проводить вычисления с ограниченными ресурсами, такими как время и объем памяти.

В таких ситуациях использование аппроксимаций может быть полезным. Аппроксимация — это замена сложной функции или процесса более простым аналогом, который можно вычислить быстрее и с меньшими затратами. В контексте классификации, аппроксимации могут быть использованы для упрощения вычислений, снижения времени обучения модели и оптимизации ее производительности.

Одним из наиболее распространенных методов использования аппроксимаций является замена сложных функций более простыми моделями, такими как линейная или полиномиальная регрессия. Вместо вычисления сложной функции непосредственно, используется более простая модель, которая представляет собой приближение сложной функции. Это может позволить существенно снизить вычислительную сложность и ускорить обучение модели.

Однако, использование аппроксимаций влечет за собой потерю точности. Приближение сложной функции более простой моделью может привести к ошибкам в вычислениях и снижению качества классификации. Поэтому, необходимо тщательно выбирать методы и параметры аппроксимации, чтобы балансировать между вычислительной эффективностью и точностью результата.

Кроме того, аппроксимации могут быть полезными при работе с большими объемами данных. Вместо использования всей выборки данных, можно использовать ее подмножество или сократить размерность данных с помощью методов, таких как главные компоненты или принцип главных кластеров. Это позволит сократить объем вычислений и ускорить обучение модели без значительной потери информации.

Использование аппроксимаций при вычислениях является важным инструментом в области классификации. Правильное применение аппроксимации позволяет снизить вычислительную сложность и ускорить обучение моделей, что особенно актуально при работе с большими данными и ограниченными ресурсами. Однако, необходимо быть внимательным и учитывать потерю точности и возможные ошибки при использовании аппроксимаций.

🔍 Видео

#29. Метрические методы классификации. Метод k ближайших соседей | Машинное обучениеСкачать

Занятие 15. Классификация в Scikit-learnСкачать

Линейная классификация // Линейные алгоритмы в анализе данныхСкачать

Машина опорных векторов за 5 минутСкачать

Машинное обучение для чайниковСкачать

#16. Байесовский вывод. Наивная байесовская классификация | Машинное обучениеСкачать

12.2 Метод ближайших соседей - KNNСкачать

#36. Логические методы классификации | Машинное обучениеСкачать

Классификация видов машинного обученияСкачать

КЛАССИФИКАЦИЯ В МАШИННОМ ОБУЧЕНИИ на Python. ТОП-7 АЛГОРИТМОВ КЛАССИФИКАЦИИ. Алгоритмы на пальцах!Скачать

Машинное обучение. Байесовская классификация. К.В. Воронцов, Школа анализа данных, Яндекс.Скачать

КЛАСТЕРИЗАЦИЯ В МАШИННОМ ОБУЧЕНИИ ДЛЯ НОВИЧКОВ на Python. Метод k-средних или k-means ПРОСТО!Скачать

Методы и алгоритмы решения задач классификации и рекомендации текстовСкачать