Многоклассовая классификация – это одна из важнейших задач машинного обучения, которая заключается в разделении объектов на несколько классов, принадлежность к которым определяется на основе набора признаков. Данная задача имеет широкое практическое применение в областях, таких как компьютерное зрение, обработка естественного языка, медицина, финансы и других.

Для решения задачи многоклассовой классификации существует множество алгоритмов, которые различаются по своей структуре и принципу работы. В основе большинства универсальных алгоритмов лежит идея использования механизмов бинарной классификации для каждого класса по отдельности. Некоторые из наиболее распространенных алгоритмов включают логистическую регрессию, метод опорных векторов (SVM), случайный лес и нейронные сети.

Примеры многоклассовой классификации включают распознавание и классификацию изображений, автоматическую категоризацию текстовых документов, предсказание типов зданий по спутниковым данным и т.д. В каждом из этих примеров алгоритмы многоклассовой классификации могут справиться с задачей, определяя и разделяя объекты на различные классы в соответствии с их признаками.

- Многоклассовая классификация:

- Определение и принципы

- Проблемы и сложности

- Алгоритмы многоклассовой классификации

- Основы многоклассовой классификации

- Метод один против всех

- Метод один против одного

- Метод иерархической классификации

- Алгоритмы многоклассовой классификации

- Метод опорных векторов

- Логистическая регрессия

- Случайные леса

- Примеры многоклассовой классификации

- Классификация изображений

- Классификация текстов

- Классификация звуковых файлов

- 📺 Видео

Видео:#28. Многоклассовая классификация. Методы one-vs-all и all-vs-all | Машинное обучениеСкачать

Многоклассовая классификация:

Основа алгоритмов многоклассовой классификации — это обучающая выборка, состоящая из объектов с уже известными метками классов. Алгоритмы обучаются на этой выборке и находят закономерности для определения принадлежности объектов к определенным классам.

Один из наиболее популярных алгоритмов многоклассовой классификации — это метод опорных векторов (SVM). Он основан на принципе максимизации зазора между классами и позволяет классифицировать объекты в многомерном пространстве.

Другие примеры алгоритмов многоклассовой классификации включают в себя логистическую регрессию, метод ближайших соседей (k-NN), случайный лес и нейронные сети.

Многоклассовая классификация имеет множество практических применений, включая распознавание образов, анализ текста, медицинскую диагностику, финансовый анализ и т. д. Эта задача является важной составляющей машинного обучения и помогает автоматизировать процессы принятия решений на основе больших объемов данных.

Определение и принципы

Принципы многоклассовой классификации основаны на алгоритмах машинного обучения, которые используются для построения модели, способной отнести объекты к определенным категориям.

Одним из наиболее распространенных алгоритмов многоклассовой классификации является метод опорных векторов (SVM). Он основан на построении гиперплоскости, которая разделяет данные на несколько классов. Другим популярным алгоритмом является случайный лес, который представляет собой ансамбль решающих деревьев.

При решении задачи многоклассовой классификации необходимо учитывать особенности выборки, тип данных и особенности конкретной задачи. Важно также учесть эффективность и точность выбранного алгоритма, а также возможность его масштабируемости для работы с большими объемами данных.

- Основными принципами многоклассовой классификации являются:

- Выбор и предобработка данных;

- Выбор и обучение модели;

- Оценка результатов и улучшение модели;

- Применение модели на новых данных;

Выбор и предобработка данных включает в себя сбор и анализ информации о признаках объектов, удаление выбросов и шумов, а также масштабирование и преобразование признаков.

Выбор и обучение модели включает в себя выбор подходящего алгоритма, определение параметров модели и ее обучение на обучающей выборке.

Оценка результатов и улучшение модели включает в себя измерение качества классификации, анализ ошибок и улучшение модели путем изменения параметров или выбора другого алгоритма.

Применение модели на новых данных включает в себя использование обученной модели для классификации новых объектов и оценку ее работы на тестовых данных.

Проблемы и сложности

Еще одной проблемой многоклассовой классификации является несбалансированность классов. В некоторых случаях, один или несколько классов могут содержать гораздо больше примеров, чем другие классы. Это может привести к смещению модели в сторону более представленных классов и неправильной классификации редких классов.

Другой сложностью является выбор алгоритма для решения задачи многоклассовой классификации. Существует множество алгоритмов, таких как случайный лес, метод опорных векторов, нейронные сети и другие. Каждый из них имеет свои преимущества и недостатки, и выбор правильного алгоритма может быть сложным заданием.

Также важным аспектом является качество и разнообразие обучающих данных. Плохо подготовленные или нерепрезентативные данные могут серьезно повлиять на работу модели и ее способность правильно классифицировать примеры. Поэтому, необходимо уделить особое внимание этому аспекту при подготовке данных для многоклассовой классификации.

Алгоритмы многоклассовой классификации

Ниже представлены некоторые из наиболее популярных алгоритмов многоклассовой классификации:

- Логистическая регрессия — это линейный алгоритм классификации, который использует логистическую функцию для предсказания вероятности принадлежности объекта к каждому классу. Он может быть использован для решения как двухклассовых, так и многоклассовых задач.

- Метод опорных векторов (SVM) — это алгоритм, который строит гиперплоскости в пространстве признаков для разделения объектов разных классов. В случае многоклассовой классификации SVM может быть использован в комбинации с одним из подходов, таких как «один против остальных» или «один против других».

- Случайный лес — это алгоритм, который строит ансамбль решающих деревьев и использует голосование или среднее значение предсказаний деревьев для определения класса объекта. Случайный лес также может быть использован для многоклассовой классификации.

- Градиентный бустинг — это алгоритм, который строит ансамбль слабых моделей, таких как деревья решений, и последовательно улучшает их путем коррекции ошибок предыдущих моделей. Градиентный бустинг также может быть применен для решения задачи многоклассовой классификации.

Каждый из этих алгоритмов имеет свои преимущества и недостатки, и выбор конкретного алгоритма может зависеть от специфики задачи и доступных данных. Важно провести тщательное сравнение и анализ алгоритмов перед принятием решения о применении.

Видео:Линейная классификация // Линейные алгоритмы в анализе данныхСкачать

Основы многоклассовой классификации

Для решения задачи многоклассовой классификации используются различные алгоритмы и методы. Некоторые из наиболее популярных алгоритмов включают в себя метод опорных векторов (SVM), случайный лес, градиентный бустинг и нейронные сети.

Одним из основных подходов в многоклассовой классификации является один против всех (one-vs-all) подход. При использовании этого подхода каждый класс рассматривается отдельно от всех остальных классов. То есть, для каждого класса строится модель, которая отличает его от всех остальных. Затем, объект классифицируется на основе того, какая модель дает наибольшую вероятность принадлежности к данному классу.

Другим подходом к многоклассовой классификации является один против одного (one-vs-one) подход. При использовании этого подхода каждая пара классов рассматривается отдельно. Для каждой пары классов строится модель, которая отличает один класс от другого. Затем, объект классифицируется на основе голосования между всеми моделями.

В таблице ниже приведены примеры алгоритмов многоклассовой классификации:

| Алгоритм | Описание |

|---|---|

| Метод опорных векторов (SVM) | Находит гиперплоскость, которая максимально разделяет классы в многомерном пространстве |

| Случайный лес | Комбинация нескольких деревьев принятия решений для улучшения качества классификации |

| Градиентный бустинг | Последовательное построение моделей, каждая из которых исправляет ошибки предыдущих моделей |

| Нейронные сети | Моделируют работу мозга с использованием искусственных нейронов и связей между ними |

Выбор подхода и алгоритма в многоклассовой классификации зависит от многих факторов, включая характеристики данных, сложность задачи и требования к точности классификации. Важно также учитывать возможность комбинирования различных алгоритмов и подходов для достижения наилучшего результата.

В зависимости от постановки задачи многоклассовая классификация может иметь различные приложения, включая распознавание образов, диагностику заболеваний, анализ текстов и многие другие.

Метод один против всех

При использовании метода один против всех каждый классификатор обучается для различения одного класса от всех остальных. Например, если задача состоит в классификации изображений с животными (собака, кошка, заяц), будет создано три классификатора: один для определения, является ли изображение собакой или нет, второй — для определения, является ли изображение кошкой или нет, и третий — для определения, является ли изображение зайцем или нет.

Для обучения каждого классификатора используется обучающая выборка, в которой классификаторы этого класса помечаются положительными примерами, а объекты других классов помечаются отрицательными примерами.

После обучения классификаторов применяются к новым данным и возвращаются имеющиеся классификаторы. Классификатор, который дает наибольшую уверенность в принадлежности объекта к классу, считается предсказанием модели.

Метод один против всех широко используется в различных областях машинного обучения, таких как распознавание образов, обработка естественного языка и биоинформатика. Он демонстрирует хорошую производительность и может быть эффективно применен к большим и сложным задачам классификации.

Метод один против одного

Процесс обучения метода один против одного включает в себя следующие шаги:

- Выбор двух классов из полного набора классов;

- Формирование обучающего набора данных, включающего только данные из выбранных классов;

- Обучение бинарного классификатора на основе обучающего набора данных;

- Повторение этих шагов для всех возможных комбинаций классов.

Когда классификаторы обучены, для классификации нового примера необходимо прогнать его через каждый из классификаторов и определить, к какому классу относится пример чаще всего.

Преимуществом метода один против одного является то, что он позволяет классифицировать примеры, даже если они принадлежат к классу, который не использовался в обучающем наборе данных для данного классификатора. Кроме того, этот метод работает эффективно даже для большого числа классов.

Тем не менее, метод один против одного может быть вычислительно сложным, если число классов очень большое, так как требует обучения всех возможных бинарных классификаторов.

Важно выбирать метод классификации, учитывая особенности и требования конкретной задачи. При необходимости можно использовать метод один против одного для решения многоклассовой классификации.

Метод иерархической классификации

Основная идея метода заключается в разделении классов на более мелкие подклассы, которые имеют более схожие характеристики. При этом каждый подкласс может быть классифицирован отдельно по своим уникальным признакам. Это позволяет повысить точность классификации и снизить сложность задачи.

В методе иерархической классификации используется дерево классов, где каждый узел представляет собой подкласс, а ветви — связи между классами. Классификация происходит по мере спуска по дереву от корневого узла к листьям. В каждом узле происходит выбор наилучшего классификатора для дальнейшей классификации.

Преимуществом метода иерархической классификации является возможность учитывать иерархическую структуру классов, что позволяет улучшить качество классификации. Кроме того, этот метод позволяет справиться с проблемой несбалансированных данных, когда один класс содержит значительно больше примеров, чем остальные.

Однако метод иерархической классификации имеет и некоторые ограничения. При построении дерева классов требуется иметь заранее заданную иерархическую структуру, что может быть затруднительно в реальных задачах. Кроме того, этот метод требует больше вычислительных ресурсов по сравнению с другими методами многоклассовой классификации.

Видео:КЛАССИФИКАЦИЯ В МАШИННОМ ОБУЧЕНИИ на Python. ТОП-7 АЛГОРИТМОВ КЛАССИФИКАЦИИ на Практике!Скачать

Алгоритмы многоклассовой классификации

Существует несколько алгоритмов, которые могут быть использованы для многоклассовой классификации:

- Метод один против всех (One-vs-All): При использовании этого метода каждый класс рассматривается как отдельная задача бинарной классификации. Для каждого класса обучается отдельный классификатор, который пытается разделить данный класс от всех остальных классов. После обучения всех классификаторов, объекты могут быть классифицированы путем применения каждого классификатора к объекту и выбора класса с наибольшим значением.

- Метод один против одного (One-vs-One): Этот метод рассматривает каждую пару классов как задачу бинарной классификации. То есть, для каждой пары классов обучается отдельный классификатор, который разделяет эти два класса. При классификации нового объекта все классификаторы применяются к объекту, и класс с наибольшим количеством успешных классификаций выбирается в качестве результата.

- Метод иерархической классификации: Этот метод основан на иерархической структуре классов. Классы разбиваются на подклассы, а затем на под-подклассы, создавая иерархию классификации. Классификация начинается с верхнего уровня и движется вниз по иерархии, пока не достигнет конкретного класса.

Каждый из этих алгоритмов имеет свои преимущества и недостатки, и правильный выбор зависит от конкретной задачи многоклассовой классификации.

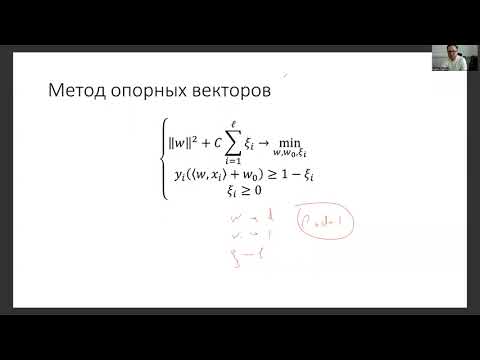

Метод опорных векторов

Основная идея метода опорных векторов заключается в том, чтобы найти такую гиперплоскость, которая разделяет два класса максимально удаленным образом. Гиперплоскость определяется таким образом, чтобы минимизировать ошибки классификации и максимизировать отступы между классами.

Для построения гиперплоскости метод опорных векторов использует опорные векторы — это образцы, которые находятся на границе разделения классов. Опорные векторы играют ключевую роль в построении гиперплоскости.

Одной из особенностей метода опорных векторов является его способность работать с нелинейными пространствами признаков. Для этого применяется так называемое ядро (kernel), которое позволяет преобразовать исходное пространство признаков в новое пространство более высокой размерности, в котором данные становятся линейно разделимыми.

Метод опорных векторов широко применяется в таких областях как компьютерное зрение, биоинформатика, распознавание рукописного текста и многие другие. Он имеет надежные математические основы и показывает хорошие результаты даже при работе с большими объемами данных и сложными задачами многоклассовой классификации.

Логистическая регрессия

Основная идея логистической регрессии состоит в том, что она моделирует зависимость между признаками объекта и вероятностью его принадлежности к определенному классу с помощью логистической функции. Логистическая функция преобразует линейную комбинацию признаков в интервал от 0 до 1, что позволяет интерпретировать результаты как вероятности.

Для обучения логистической регрессии используется метод максимального правдоподобия. Этот метод подбирает параметры модели таким образом, чтобы вероятность принадлежности объектов тренировочного набора к их реальному классу была максимальной.

Примерами задач, в которых применяется логистическая регрессия, являются предсказание отклика на рекламу (клик или не клик), распознавание образов (например, определение, является ли изображение кошкой или собакой) и анализ медицинских данных (например, предсказание наличия заболевания на основе симптомов).

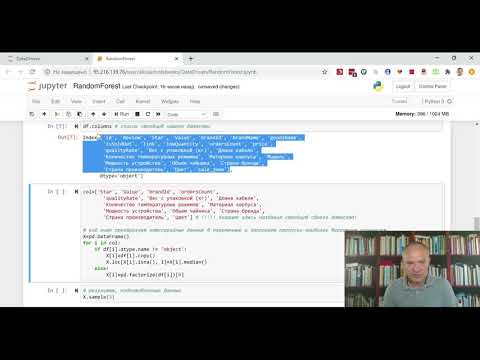

Случайные леса

В случайных лесах используется принцип баггинга (bootstrap aggregating) – данные разбиваются на несколько подвыборок, и для каждой подвыборки строится отдельное дерево решений. Следующий этап – сочетание предсказаний всех построенных деревьев. Оно основывается на голосовании большинства (для классификации) или на усреднении (для регрессии) предсказаний каждого отдельного дерева.

Главное преимущество случайных лесов заключается в их способности обрабатывать большие объемы данных и устойчивости к переобучению. Также они позволяют оценивать важность каждого признака с использованием метода перестановки и использовать его для дальнейшего отбора признаков.

Для построения случайного леса важными параметрами являются количество деревьев, глубина каждого дерева и количество признаков, используемых для построения каждого разбиения. Они должны выбираться оптимально для каждой конкретной задачи, чтобы достичь наилучшей производительности модели.

Примерами успешного применения случайных лесов являются задачи определения фрода в банковской сфере, диагностики заболеваний на основе медицинских данных, анализа клиентской базы и многих других. Данный алгоритм обладает широкими возможностями и хорошо справляется с разнообразными задачами машинного обучения.

| Преимущества случайных лесов | Недостатки случайных лесов |

|---|---|

| — Устойчивость к переобучению — Высокая точность предсказаний — Возможность оценивания важности признаков — Универсальность применения | — Больший объем требуемой памяти — Большое количество параметров, которые нужно настроить — Более долгое время обучения по сравнению с некоторыми другими алгоритмами |

Видео:Машинное обучение для чайниковСкачать

Примеры многоклассовой классификации

1. Классификация изображений

Одним из примеров многоклассовой классификации является задача классификации изображений. В этом случае, алгоритм обучается распознавать и классифицировать изображения в соответствии с заранее определенными классами. Например, алгоритм может быть обучен распознавать изображения животных и классифицировать их по видам: собаки, кошки, птицы и т.д.

2. Анализ тональности текста

Другим примером многоклассовой классификации является анализ тональности текста. В этом случае, алгоритм обучается определять эмоциональную окраску текста и классифицировать его по нескольким классам. Например, алгоритм может быть обучен определять, является ли текст положительным, отрицательным или нейтральным.

3. Распознавание рукописных символов

Еще одним примером многоклассовой классификации является задача распознавания рукописных символов. Алгоритм может быть обучен классифицировать символы на основе их форм и структуры. Например, алгоритм может быть обучен распознавать и классифицировать буквы алфавита или цифры.

Многоклассовая классификация широко используется в различных областях, включая медицину, финансы, маркетинг и многие другие. Это мощный инструмент, который помогает автоматизировать процесс принятия решений и улучшить предсказательные модели.

Классификация изображений

Классификация изображений представляет собой задачу машинного обучения, в которой требуется определить, к какому классу относится данное изображение. Эта задача имеет множество практических применений, включая распознавание лиц, детектирование объектов, медицинскую диагностику и многое другое.

Для классификации изображений используются различные алгоритмы машинного обучения, включая нейронные сети, метод опорных векторов и деревья принятия решений. Данные алгоритмы тренируются на большом наборе изображений, в которых классы заранее известны, чтобы научиться правильно определять классы новых изображений.

Классификация изображений основывается на анализе различных признаков изображения, таких как цвет, текстура и форма. Алгоритмы машинного обучения обрабатывают эти признаки и присваивают изображению класс, который наиболее соответствует его характеристикам.

Одна из основных проблем в классификации изображений — это наличие большого количества классов. В многоклассовой классификации требуется определить класс из общего числа возможных классов, что может быть сложной задачей. Для решения этой проблемы используются различные подходы, такие как иерархическая классификация и ансамбли моделей.

Классификация изображений имеет большое значение в современном мире, где с каждым днем происходит все большее количество создания и обработки изображений. Продвижение в этой области позволяет автоматизировать множество задач и облегчить работу людям в различных областях деятельности.

Классификация текстов

Классификация текстов имеет широкое применение и используется во многих областях, таких как анализ тональности текстов, определение языка, спам-фильтрация, категоризация новостей и т.д.

Для решения задачи классификации текстов применяются различные алгоритмы и методы машинного обучения, такие как метод наивного Байеса, метод максимальной энтропии, метод опорных векторов и другие. Эти алгоритмы основаны на различных подходах и используют различные признаки текста для его классификации.

В процессе классификации текстов необходимо предварительно подготовить данные, провести токенизацию – разбиение текста на отдельные слова или токены, провести лемматизацию – приведение слов к их леммам, устранение стоп-слов – удаление часто встречающихся слов-паразитов, а также провести векторизацию – преобразование текста в числовой вектор.

После предварительной обработки данных происходит обучение модели, которая на основе предоставленных обучающих данных будет классифицировать новые тексты. После обучения модели необходимо провести тестирование для оценки ее качества и точности.

Классификация текстов – это сложная задача, так как тексты могут быть очень разнообразными и содержать большое количество информации. Однако современные алгоритмы классификации и методы машинного обучения позволяют достичь высокой точности в решении этой задачи.

Классификация звуковых файлов

Для классификации звуковых файлов используются различные алгоритмы и методы, такие как Gaussian Mixture Models (GMM), Hidden Markov Models (HMM), Support Vector Machines (SVM), Deep Neural Networks (DNN) и другие.

Процесс классификации звуковых файлов включает следующие шаги:

| Шаг | Описание |

|---|---|

| 1 | Предварительная обработка звуковых данных, включающая их нормализацию и фильтрацию |

| 2 | Извлечение характеристик звуковых файлов, таких как спектральные коэффициенты или мел-частотные кепстральные коэффициенты (MFCC) |

| 3 | Обучение моделей классификации на основе извлеченных характеристик |

| 4 | Тестирование обученных моделей на новых звуковых файлах для определения их класса |

Применение классификации звуковых файлов имеет широкий спектр применений в различных областях. Она может использоваться для распознавания голоса, выявления аномалий в аудиоданных, анализа музыки или звукового окружения и многого другого.

В зависимости от конкретной задачи и типа звуковых файлов выбираются соответствующие методы и алгоритмы классификации, чтобы достичь наилучших результатов.

📺 Видео

Занятие 15. Классификация в Scikit-learnСкачать

#36. Логические методы классификации | Машинное обучениеСкачать

RandomForest - очень просто о том, как использовать классификацию в PythonСкачать

#29. Метрические методы классификации. Метод k ближайших соседей | Машинное обучениеСкачать

#9. Пример использования SGD при бинарной классификации образов | Машинное обучениеСкачать

#16. Байесовский вывод. Наивная байесовская классификация | Машинное обучениеСкачать

Основы машинного обучения, лекция 11 — SVM, многоклассовая классификацияСкачать

Введение в Машинное Обучение (Машинное Обучение: Zero to Hero, часть 1)Скачать

Многоклассовая классификация текста на PythonСкачать

11 класс, 24 урок, Статистические методы обработки информацииСкачать

КЛАССИФИКАЦИЯ В МАШИННОМ ОБУЧЕНИИ на Python. ТОП-7 АЛГОРИТМОВ КЛАССИФИКАЦИИ. Алгоритмы на пальцах!Скачать

#6. Решение простой задачи бинарной классификации | Машинное обучениеСкачать

Логистические методы классификацииСкачать

Алгоритм k-ближайших соседей // Основы машинного обученияСкачать